Hola, soy Alex Rayón Jerez. De #bilbao y #millennial (por los pelos).

Bienvenido/a a mi newsletter Digital & Data. Damos una especial bienvenida a los 41 nuevos suscriptores/as con los que somos ya 9.045 reflexionando sobre cómo los humanos no entendemos una tecnología hasta que no la adoptamos masivamente. Que es, precisamente, lo que está ocurriendo con las tecnologías digitales.

Suscríbete aquí 👇

📷 Una imagen

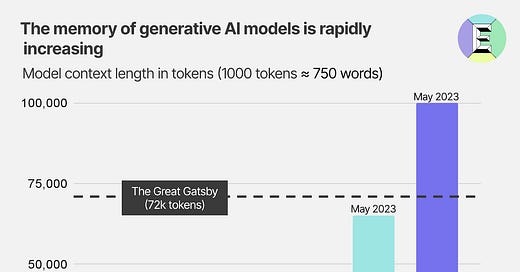

Las “ventanas de contexto”, que podríamos traducir, para entendernos, en la “memoria” de los LLM (modelos de lenguaje), no paran de crecer. Estas “ventanas de contexto”, de forma más técnica y funcional, es la longitud del texto que un LLM puede procesar y responder. Por eso también podríamos llamarle la memoria, en el contexto de un diálogo. Anthropic, una empresa de la que se habla menos que de OpenAI, ha lanzado una nueva versión de Claude, su LLM, que permite pasar de 9.000 a 100.000 tokens (unas 75.000 palabras). Esto no solo permite tener conversaciones más largas, sino también analizar documentos más complejos. Los 8.000 tokens de GPT-4 son claramente una limitación para alguna de las tareas que ya hago en mi día a día apoyado de ChatGPT. Por ejemplo, la detección de patrones para ver si mis estudiantes han utilizado ChatGPT o no (ya sabemos que no los softwares anti-plagio son incapaces de detectarlo). ¿Por qué esta memoria es importante? Porque no podremos de otra forma mantener conversaciones largas; ergo, no podríamos tener asistentes diarios en todos los contextos. Y porque te permite procesar libros enteros, literalmente, en segundos. También podrá personalizar los resultados mejor (me sorprende cuando la gente dice que “ChatGPT no devuelve siempre lo mismo” que no tengan en cuenta que el resultado es emergente y personalizado…). Si la guerra por tener más tokens que tu vecino era poco, ahora viene la guerra por tener más memoria que tu vecino. Es, de largo, una revolución de computación de altas prestaciones y grandes volúmenes de datos, y no tanto de algoritmia.

📚 Cinco lecturas

Esta semana Sam Altman, uno de los co-fundadores y actual CEO de OpenAI, ha acudido a testificar al Senado de Estados Unidos. Las 3 horas las tenéis aquí (podéis con https://govizle.com/video-to-text/ convertirlo a PDF, y luego con chatpdf.com hacer un resumen si lo preferís -¡meted la IA en vuestras vidas, es productividad!-). Os resumo la principal idea: parece que todo el mundo llega a la conclusión que la IA debe ser regulada antes de que se vaya de las manos. Y, también llegan a la conclusión que, esta regulación, es tan compleja, que nadie sabe cómo hacerla. También dice que necesitamos una agencia federal que permita establecer ciertas directrices de cómo deberían ser los productos que usen la IA. Yo llevo años haciendo analogías con la industria farmacéutica o alimenticia: no puedes sacar ningún fármaco o alimento sin una larga cadena de aprobación. Históricamente lo decía para las apps que se meten en nuestras vidas de forma invasiva. Ahora lo digo para estas herramientas de IA. Y es que, como dice Altman en la intervención, el mayor riesgo es que las IAs comiencen a tomar decisiones de diseño y desarrollo. Y ahí, sí, estaríamos sin manos al volante.

Esta semana estrenamos nueva CEO en Twitter: Linda Yaccarino, una ejecutiva bastante conocida en el sector de los medios. En algunos análisis que he leído de su perfil, parece que se trata de una directiva que le gusta trabajar con liderazgos fuertes y marcados al lado. Esto puede explicar por qué acepta este puesto, y porque lo hace sabiendo que Elon Musk seguirá siendo Presidente y CTO. No tiene pinta que vaya a tener un rol pasivo, ciertamente. Cuando se hacen estos nombramientos hay mucho Test de Rorschach: cada uno hacemos nuestra lectura, pensando en lo que nosotros mismos aguantaríamos al lado. Sin embargo, debemos entender que las personalidades múltiples que llevamos todos dentro, nos hace adaptarnos de forma diferente a cada persona. Según Musk, Yaccarino se centrará en desarrollo de negocio, y él en el producto. Recordemos que Twitter tiene un producto de los más complicados (moderación de contenidos de alta variabilidad), y que su reputación no lo hace precisamente de los mejores lugares para anunciar una marca. En cuanto a la moderación de contenidos, esta semana Musk ha bloqueado contenidos en Turquía tras la petición de Erdogan. No sé si así se construye un producto ciertamente…. (ya veréis cuando venga China a pedir, con lo que depende Tesla y sus fábricas de China). Quién sabe cómo acabará esto. Mientras tanto, sabemos que Meta va a lanzar un competidor a Twitter que parece, se integrará en Instagram.

Siempre mostraré mi sorpresa cuando veo la cantidad de gente que reenvía estudios e informes hechos en el sector tecnológico sin cuestionar quién está detrás. Este estudio elaborado por Deloitte, y financiado por Meta, dice que el metaverso podría aportar 3.600.000.000 de dólares a la economía mundial para 2035. En ocasiones me piden que incluya este tipo de informes en artículos o documentos que me encargan. Y muchas veces no lo autorizo, por el mero hecho de que trato de explicar que no puedo exponer mi nombre con estudios que claramente son interesados. En este caso, Meta trata de revivir el metaverso. No creo que esté muerto ciertamente. Pero que le va a costar llegar a la sociedad, sí.

Los que me conocéis, sabéis que llevo mucho tiempo criticando los datos de audiencias online y de tráfico en sitios. El motivo no es otro que los terroríficos datos de tráfico que se pueden ver cada año provenientes de bots (robots de comportamiento autónomo): y es que en 2022, el tráfico de Internet de los bots es cada del 50%. De este tráfico, se calcula ya que el 30% es malicioso. Por este tipo de cuestiones suelo decir mucho últimamente que uno de los puestos más críticos en cualquier organización es el que estimule la demanda (lo que podríamos llamar marketing y ventas) y que la analítica digital debiera conocerla hasta el CEO de cualquier organización. De otra forma, la probabilidad de caer en métricas de vanidad es muy alta. El CEO está tranquilo, el de marketing cumple su papel (dar datos que gusten) y, supuestamente, avanzamos.

He pasado centenares, miles, de horas de mi vida en Stack Overflow. Es el foro donde los nerds de la programación y feos biológicos como yo nos juntábamos para ayudarnos a resolver retos de sintaxis, de lógica, de estructuras de control, etc. Pues bien, su tráfico ha caído un 14% desde la llegada de ChatGPT, según datos de Similarweb. Yo estoy en ese 14% que lo ha dejado de usar. Y es que con ChatGPT, ahora puedo generar juegos de datos para los proyectos y las clases, entender mejor el código de otros, interpretar en tiempo real, y muchas otras cosas. Las clases ahora las doy con ChatGPT o Perplexity al lado. Cuando alguien me pregunta algo, le digo que mi valor añadido ante esa pregunta no es tan alto como antes. Abro ChatGPT, y traduzco su pregunta a sintaxis de prompts. Creo que le ayudo más así, enseñándole a buscarse la vida (el prompting de programación también tiene sus cosas). El problema de falta de talento tecnológico se va a resolver en buena medida con este tipo de técnicas. ¿Para cuándo un curso de prompting para ser mejor y más productivo programador? 😊

🔊 Un audio

Esta semana estuve en una larga conversación en EITB alrededor de la Inteligencia Artificial y lo que nos deparará. En esta newsletter estáis mucha gente más allá de la capital de Europa, por lo que os lo enlazo aquí. Hay algunas piezas de contenido sintético. A ver si las detectáis ;-)

💬 Un comentario en redes sociales

OpenAI ha lanzado su aplicación oficial de ChatGPT para iOS. La aplicación solo está disponible de momento en EEUU, no tiene anuncios y será gratuita la app (algún día hablamos de la sostenibilidad ambiental y no la internalización de costes). Y, Google, una semana más, no ha reaccionado ante ello. Lógicamente, ante una alternativa sin publicidad, es previsible que mucha gente se mueva. Es lo que ha pasado precisamente desde que Bing AI Chat se lanzó como app. Sus descargas se han cuadriplicado. No olvidemos nunca que el 60% del mercado de la atención (nuestro consumo digital) es móvil o en movilidad. Por lo que si nos acostumbramos a buscar, aprender, etc. interactuando con una aplicación que nos asiste en ello, ahí habrá mucha atención. Y por lo tanto, habrá algún día un modelo de negocio y económico.

🎲 Una lectura aleatoria

El libro “Why we sleep”, de Matthew Walker, me cambió la perspectiva de muchas cosas. Con amplia evidencia empírica en sus textos (esto de dormir tiene muchos mitos…), nos viene a decir que el factor que mejor explica nuestro envejecimiento saludable y la longevidad es el sueño. Nadie puede envejecer bien sin dormir al menos 7 horas. Por debajo de ese umbral, la probabilidad de no hacer daño a tu salud es prácticamente nula. Dormir regularmente 8 horas mejora la memorización, concentración, creatividad, estabiliza las emociones, fortalece el sistema inmunitario, la fortaleza física para la práctica deportiva y ayuda a evitar enfermedades graves de corazón o cáncer. Que nuestro cerebro permute los ciclos REM con los NREM, ayuda al aprendizaje y memorización. Son los ciclos que transfieren la información acumulada de un día (memoria a corto plazo) al largo plazo. Estas imágenes que creamos en los ciclos REM, fomentan nuestra creatividad. ¡Sueña! Más ideas tendrás! Y, ¿Cómo dormir mejor? Muchas formas, especialmente bien resumidas al final de este artículo.

📰 En medios

“Intriga y provocación. Promesa de emoción” [Cadena Ser, 18/5/2023]

“Inteligencia Artificial: ¿hasta dónde puede llegar?” [EITB, 19/5/2023]

¡Muchas gracias por la newsletter! Siempre es muy interesante, pero esta semana es redonda.

No conocía Perplexity, ¡mola! apuntadísima😊