❓# 188 Hacia los buscadores semánticos y mi uso de NotebookLM

Semana 188: Elon Musk como actor político y Foursquare se va de nuestras vidas

Hola, soy Alex Rayón Jerez. De #bilbao y #millennial (por los pelos).

Bienvenido/a a mi newsletter Digital & Data. Damos una especial bienvenida a los 79 nuevos suscriptores/as con los que somos ya 14.335 reflexionando sobre cómo los humanos no entendemos una tecnología hasta que no la adoptamos masivamente. Que es, precisamente, lo que está ocurriendo con las tecnologías digitales. Suscríbete aquí 👇

📷 Una imagen

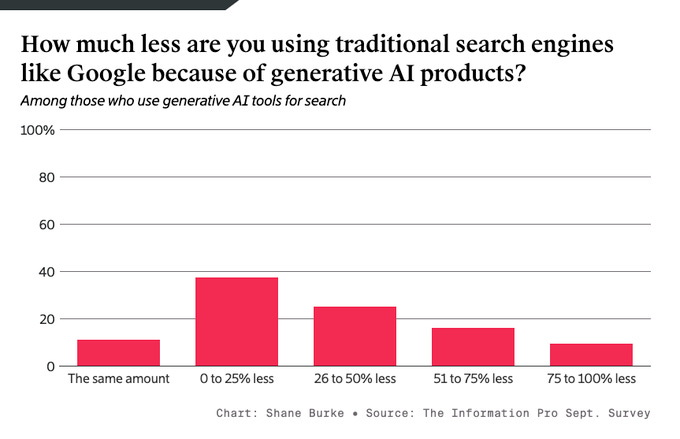

Esta semana, intensa nuevamente, hemos conocido que por fin ChatGPT ha anunciado su producto de búsqueda semántica. Por búsqueda semántica me refiero a un producto de búsqueda en el que a diferencia de los tradicionales buscadores léxicos, aquí puedes expresar tu idea desde el contexto. Por ejemplo: “Localízame un hotel en Sevilla que, me permita ir con mi mascota, tenga al menos 20 metros cuadrados la habitación, esté en un radio de menos de 100 metros de los siete lugares culturales que sean de mi interés y que caminando como mucho se eleve 200 metros”. Decidme cómo hacer esta búsqueda con los buscadores tradicionales. No, no es fácil. La gráfica de hoy la traigo de esta encuesta que ha hecho The Information. Como veis, cada vez más gente usa buscadores semánticos en lugar de léxicos. El concepto “palabra clave”, que ha gobernado Internet durante muchos años, servía para buscar léxicamente. ¿Cuál será la unidad de expresión ahora? ¿las características del servicio bien descritas? Es evidente que deberemos pensar en que si ahora se empieza a buscar de forma diferente, el contenido de nuestro sitio web, deberá ser igualmente expresado de forma diferente. En este hilo, se comparan los tres productos mejor posicionados para la búsqueda semántica: Perplexity Pro vs. ChatGPT Search vs. Google AI Overview. Yo tengo los dos primeros. Son una pasada. Yo soy de esos que solo busco ya ahí.

📚 Cinco lecturas

#1 Cómo los CEO pasan su tiempo: qué hacen y a quién llaman

Una de las cosas que siempre me he preguntado más es qué tareas hacen los máximos responsables de estas grandes compañías que están cambiando el mundo. Satya Nadella, CEO de Microsoft, tiene por rutina llamar al menos a 2 CEOs al día. Elon Musk, además de hablar con todo el mundo (incluidos presidentes de países con los que EEUU no está en su mejor momento), sale más a eventos deportivos y culturales. Pero sobre todo, Musk dedica mucho tiempo a ser diplomático. ¿Por qué?

Detalles

Hace unos días parece ser que Xi Jinping (China) llamó a Putin (Rusia) para que le pusiera en contacto con Musk. Tesla tiene una gran fábrica en Shanghai. De hecho, fue la primera que China permitió que operara sin un socio local. El propio gobierno Chino usa Teslas.

Cuando Musk compró Twitter (X), y empezó a destruir su valor, criticábamos lo que estaba ocurriendo. Todos somos muy listos en pijama desde casa. Pero nadie vimos venir que, con los datos generados en Twitter, xAI (la IA Generativa de Twitter) podría llegar a valer 45.000.000.000 dólares. Es la materia prima lo que vale en estos agentes; qué tienes para entrenarte. Y para Musk, era un altavoz para relacionarse con el mundo y ser fuerte políticamente (Twitter es empleada en muchos países como “vía de escape” hacia las reclamaciones sociales).

¿Por qué es relevante?

Musk, nos guste o no, es un actor político de un calibre mundial. Si gana Trump (¡!), más aún que lo será. Milei ha optado por la reducción del déficit público para frenar la inflación en Argentina. Lo mismo dice Musk como Ministro de Recortes. La tecnología es un agente político de primer nivel hoy en día. Más poderosa que muchos estados.

#2 Los detectores de plagio en la era de la IA en educación

Este próximo lunes estaré en uno de mis podcast favoritos (Heavy Mental). Hablaremos de la llegada de la Inteligencia Artificial a la educación, a todos los niveles. Tenemos como clientes a colegios, academias, centros de FP, universidades y educación corporativa de empresas. En todas ellas, el reto es el mismo: cómo convivir con la IA, con estudiantes que lo emplean para literalmente de todo (trust me). Estudiantes que, en la mayoría de los casos, lo hacen sin que sus profesores se den la más mínima cuenta (trust me). Pero, también, estudiantes, a veces, falsamente acusados (trust me). Veamos.

Detalles

Turnitin, una de las herramientas más populares, reporta una tasa de falsos positivos del 4% al analizar oraciones. Investigaciones indican que los estudiantes que no son hablantes nativos son más propensos a ser señalados incorrectamente por estos detectores.

Debido a estas inexactitudes, algunas instituciones educativas, como la Universidad de Vanderbilt, han desactivado el uso de estas herramientas para evitar acusaciones erróneas.

¿Por qué es relevante?

Además, se ha observado (hemos observado también personalmente) que los servicios de detección de IA pueden ser engañados por herramientas automatizadas diseñadas para hacer que los textos generados por IA parezcan escritos por humanos. Sin aportar el más mínimo granito de arena a la educación, esto puede acabar en una carrera entre educadores y estudiantes.

#3 NotebookLM ya en español y en mi día a día

Cada día uso más NotebookLM. Es una herramienta para la organización, descubrimiento y creación de conocimiento. La idea principal es ayudar a los usuarios a comprender una cantidad abrumadora de información. Lo uso para ir guardando cosas que no tengo tiempo de leer, pero que luego me resume, presenta y estructura brutalmente bien para dar clase o estudiar algo. Y para mucho más.

Detalles

¿Para qué más? He cogido mis últimos 16 años de emails y ahora le hago preguntas para encontrar insights o datos que no recuerdo. He subido mis datos de cuenta de la tarjeta de crédito y me ha hecho un resumen de mis hábitos de gasto. He encontrado conexiones entre cientos de artículos que estoy leyendo sobre un tema en particular mediante una "conversación" con las fuentes. Me explica conceptos complejos y artículos científicos con la función de resúmenes de audio.

Como dicen sus fundadores: “Empezamos a explorar qué podríamos construir para ayudar a las personas a establecer conexiones de conocimiento y datos de forma más ágil, especialmente utilizando fuentes que van guardando.”

¿Por qué es relevante?

Por cierto, ya está la versión en Español y la que permite personalizar el podcast. La versión en Español tengo que ajustarla un poco más aún, pero os dejo aquí un podcast de una sesión de 4 horas que impartí antes de ayer a la tarde en Pamplona a empresarios.

#4 La guerra cultural y los sesgos de la IA

Este artículo de Wired explica cómo Elon Musk no para de criticar los modelos de inteligencia artificial (IA) como ChatGPT, acusándolos de ser "woke" y políticamente correctos debido a influencias de San Francisco. Nuevamente, si gana Trump, la guerra cultural en la IA, no dejará de crecer.

Detalles

Musk argumenta que estos sesgos son problemáticos y sugiere que una posible administración de Trump podría enfocarse en regular o penalizar a compañías como OpenAI, Google, y Meta por “contaminación social”.

Estudios académicos confirman que los modelos de lenguaje pueden mostrar sesgos políticos, algunos de ellos liberales y centrados en EEUU. Dichos sesgos pueden afectar áreas como la detección de discurso de odio o desinformación. Sin embargo, como escribí hace unos meses, la existencia de sesgos es inevitable (actualmente, claro), ya que estos modelos se entrenan en grandes volúmenes de datos que contienen diversas perspectivas.

¿Por qué es relevante?

La posible manipulación de datos puede influir en los resultados de IA, generando una "carrera armamentista" en la que distintos grupos intenten inclinar los sesgos a favor de sus ideologías.

#5 Descanse en Paz Foursquare

Adiós Foursquare. Lejos quedarán aquellos días en los que la gente tenía a bien compartirnos dónde estaba y con quién estaba. En fin. O cómo el delito lo usaba para delinquir más. El modelo de negocio de estas aplicaciones nunca fue fácil. La gente no permanecía dentro de ellas mucho tiempo.

Detalles

Foursquare fue eliminada del mapa por Yelp, que a su vez fue eliminada por Google Maps. El “city mapping”, que es como se llama esta categoría de apps, lo tienen difícil en una era en la que la agregación de datos está ganando el terreno a las aplicaciones de nicho.

¿Por qué es relevante?

En Internet, ideas buenas, hay muchas. Pero como siempre el problema está en la monetización. El coste e ingreso marginal cero de esta era hace que mucha gente no está dispuesta a pagar por “micro-servicios”, por lo que acaban quedándose estas cosas las grandes, que ya ganan dinero por otros lados. Si no pagamos, no pidamos.

🔊 Un audio

Es la era de la reindustrialización. Un cambio de paradigma que traerá nuevas lógicas en las cadenas de suministro globales.

💬 Un comentario en redes sociales

De lo poco bueno que tiene la nueva Twitter/X son las notas de comunidad y las notas contextuales de la comunidad. Entiendo que los políticas y las políticas estarán mejorando en rigor y comunicación corporativa y social/digital. También cuando haces declaraciones públicas políticamente correctas y no dices lo más mínimo.

🎲 Una lectura aleatoria

Durante mis estudios de una de las dos ingenierías (Ingeniería en Informática), tuve dos asignaturas que me fascinaron intelectualmente: Compiladores I y Compiladores II. Aprendíamos en dicha asignatura cómo un ordenador interpreta lo que le pedimos y cómo genera el código para instruirse. En otras palabras: entendíamos cómo relacionarnos de forma eficiente y óptima con las máquinas. Esto para deciros que debemos “gestionar expectativas” cuando decimos que los modelos de Inteligencia Artificial razonan. Escribiré de forma más detallada lo que viene a continuación más adelante, que ahora no tengo tiempo.

Empezando por lo básico: los modelos de IA basados en LLM, no piensan en el problema a resolver. Usa exactamente la misma cantidad de computación con independencia del problema. Una cosa básica que aprendíamos en Compiladores (Teoría de la Complejidad) era básicamente que algunos problemas con entradas muy pequeñas requieren un coste computacional exponencialmente alto para ser resueltos correctamente. Estos son problemas NP-completos. Es mi rama de la algoritmia favorita. Cuando una empresa nos propone un reto, pensamos en esto. La mayoría de los científicos informáticos creen que no existen algoritmos eficientes para resolverlos. Lo crucial es que una gran cantidad de problemas de razonamiento caen en esta categoría, incluido el rompecabezas lógico más básico de todos: determinar si una fórmula lógica dada es satisfactoria. Es decir, si una empresa está afrontando bien el proceso de solución (optimización de rutas, mejora de cadenas de producción, estrategias de marketing, etc.). Cuando enfrenta una instancia de un problema NP-completo, un LLM generará una respuesta después de una cantidad fija de computación. Es decir, los LLM “están programados para dar una respuesta en tiempo finito”. Por definición formal, hay problemas que no pueden tener estos autómatas finitos. La completitud de Turing es la capacidad de un sistema computacional de realizar cualquier cálculo dado suficiente tiempo y recursos. Los ordenadores modernos y muchos sistemas aparentemente simples, como los autómatas de los móviles, son sistemas completos de Turing. Pero los LLM, irónicamente, no lo son. ¿Por qué? Su arquitectura subyacente limita los tipos de problemas que pueden resolver. La razón es simple. Sabemos, por la teoría de la complejidad, que cualquier sistema completo de Turing debe ser capaz de hacer bucles indefinidamente. Existen algunos problemas (algunas tareas de razonamiento) en los que la única solución posible es calcular, y calcular, y calcular hasta que se cumpla una condición, y la cantidad de computación requerida no puede conocerse de antemano. Los LLM han sido diseñados para dar respuesta en un tiempo finito y concreto. Están limitados computacionalmente. Sin importar su tamaño, siempre habrá instancias de problemas que requieren más computación de la disponible en la enorme cadena de multiplicaciones de matrices dentro del LLM. En definitiva, la IA razona para algunos problemas, pero no para todos. Como dijo el bueno de Chillida, es más importante el arte de la pregunta (qué problema queremos resolver) que el de la respuesta (que es como han sido diseñados los LLM).

📰 En medios

¿Te gusta esta newsletter? ¡Suscríbete! ¡Compartid el enlace con vuestros amigos! ¡Enlazad el boletín en redes sociales!